近日,计算机与信息科学学院 软件学院罗辛教授团队的研究成果《基于高阶图神经网络的动态图全局表征》(SGD-DyG: Self-Reliant Global Dependency Apprehending on Dynamic Graphs)在数据挖掘领域顶级国际会议ACM SIGKDD Conference on Knowledge Discovery and Data Mining(KDD)2025发表。

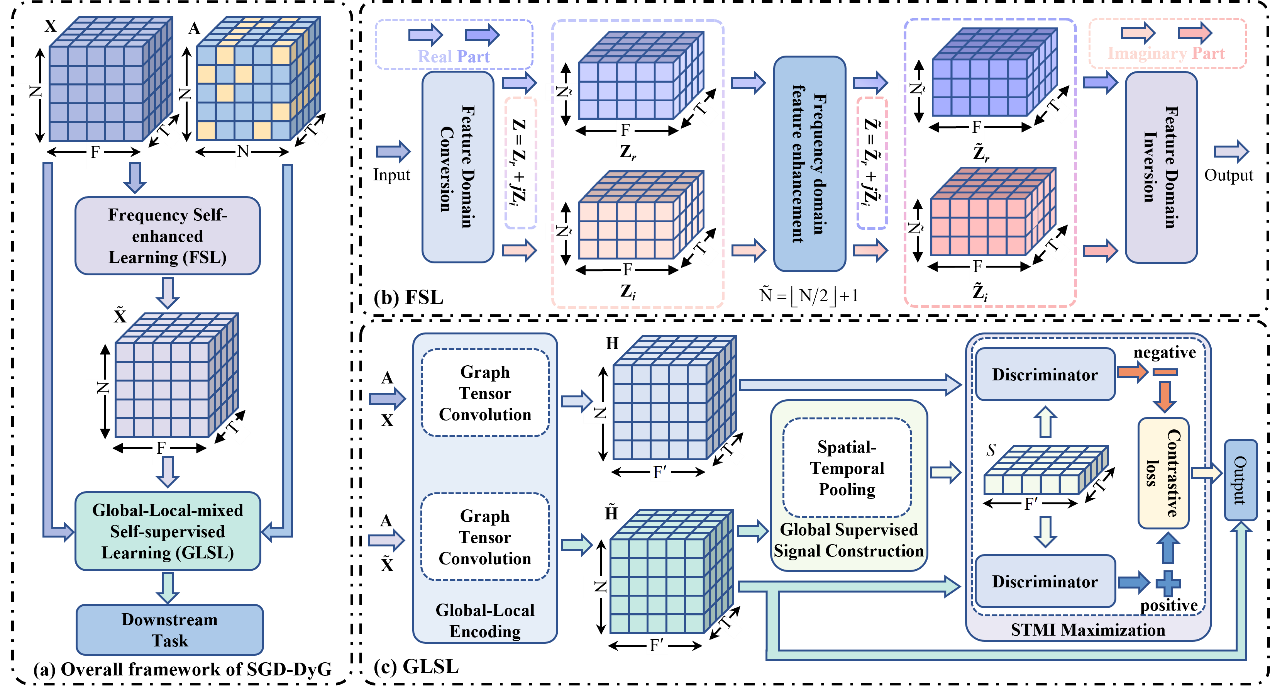

研究提出了一种新颖的动态图学习框架SGD-DyG,旨在解决现有方法在全局时空依赖学习中的不足。该框架包含两个核心模块:频率自增强学习(FSL)与全局-局部混合自监督学习(GLSL)。其中,FSL利用离散傅里叶变换将节点特征映射至频域,对实部与虚部进行增强后再经逆变换返回空间域,以挖掘独立于图结构的全局固有交互;GLSL则采用双流学习策略,将原始特征与增强特征分别输入高阶图神经网络以提取局部和全局嵌入,并通过时空池化最大化二者的时空互信息,实现动态图中局部细节与全局上下文的有效对齐。实验结果表明,在Wiki-Gl、Wiki-Eo、Digg、Alpha、OTC等七个动态图数据集上,该模型均显著优于SOTA模型,展现了优越的动态图表示能力。

KDD作为全球数据挖掘与知识发现领域的顶级会议(CCF-A类),以严格的双盲评审著称,年度录用率常年低于20%。被录用的论文需在理论方法上取得突破性创新,且具备清晰的理论证明和完整的实验分析。

西南大学为论文第一完成单位,论文作者分别为韩明廉(2023级硕士研究生)、王领、袁野、罗辛。论文链接:SGD-DyG: Self-Reliant Global Dependency Apprehending on Dynamic Graphs | Proceedings of the 31st ACM SIGKDD Conference on Knowledge Discovery and Data Mining V.2。此项研究得到国家自然科学基金的资助。

供稿:袁一野

供图:袁一野

初审:王一晖

复审:廖剑伟

终审:罗一辛